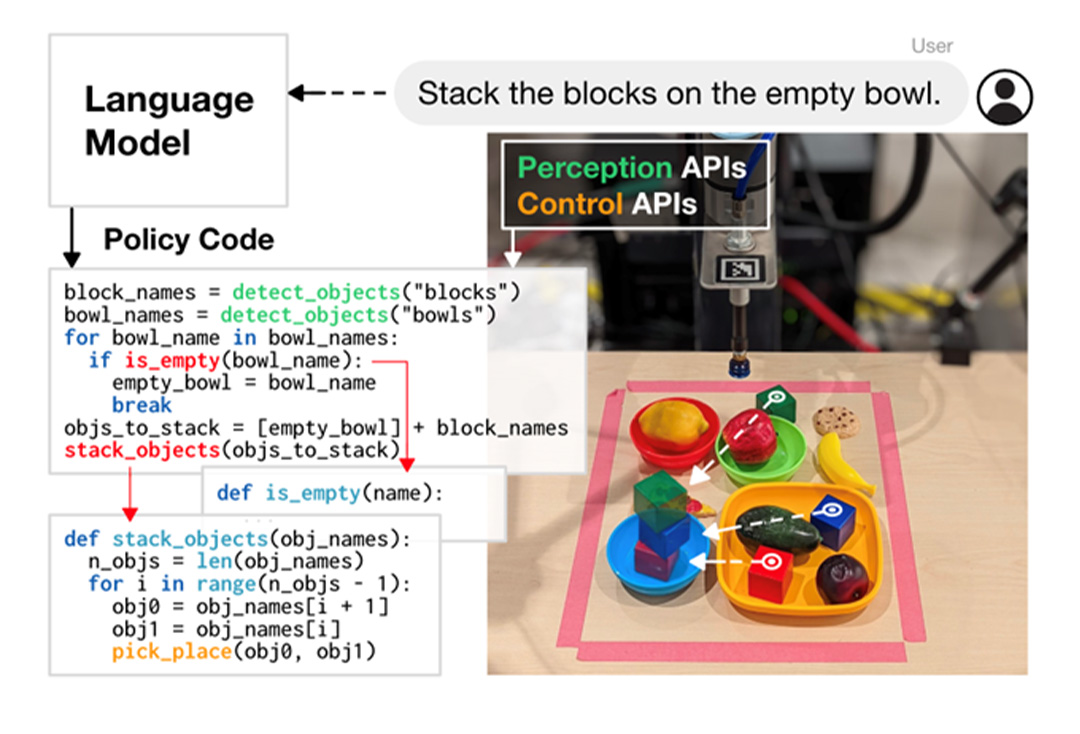

지난 11월 2일(현지시각) 뉴욕 맨해튼. 구글이 올해 4월 오픈한 신규 오피스 ‘피어 57(Pier 57)’에서 흥미로운 로봇 조작 시연이 벌어졌다. 말로 “과자를 탑처럼 쌓아봐” 같은 명령을 내리면 로봇이 이를 이해해 작업을 수행하는 시연이었다.

현장에서 로봇이 다양한 명령에 반응해 즉시 과제를 수행할 수 있었던 건 ‘실시간으로’ 자연어(Natural Language, 일상생활에서 사용하는 언어)를 기계어로 번역해 주는 기능 덕분이었다.

자연어를 기계어로 번역해준다는 건 프로그래밍이 필요 없다는 뜻이다. 기계는 0과 1로 이뤄진 기계어로 외부 정보를 인식하는데, 이런 이유로 로봇을 조작하려면 프로그램 언어로 기계에 지시를 내려야 한다. 로봇 공학자들 역시 로봇을 개발할 때 이런 프로그래밍 과정을 거친다.

한데 이 로봇은 놀랍게도 구글의 대형(LLM, Large language model) 언어 모델 ‘PaLM(Pathways Language Model)’ 기반으로 스스로 코드를 만들어 자신의 동작을 제어했다. 실제로 프로그래밍 지식이 전혀 없는 일반인도 자연어로 명령을 내려 로봇이 특정 동작을 하도록 만들 수 있었다.

현장 시연을 담당한 앤디 쩡(Andy Zeng) 구글 선임 연구 과학자(Senior Research Scientist)는 “로봇이 (기계적 성능의 한계로) 특정 명령을 수행하지 못할 수는 있지만, 명령어 자체에는 제약이 없다”고 했다.

범용 로봇 시대 빨라진다

구글은 로봇 동작 제어를 위한 이 AI(인공지능) 언어 프로그램에 ‘정책으로서의 코드(Code as Policies, CaP)’라는 이름을 붙였다. 인간의 지시를 받아 로봇이 스스로 동작 제어 코드를 생성, 인간이 원하는 걸 이뤄줄 수 있다는 의미에서다.

이 프로그램의 가장 큰 장점은 로봇이 다른 작업을 수행하도록 만들기 위해 코드를 다시 쓸 필요가 없다는 점이다. 동일한 로봇이 블록 쌓기를 할 수도 있고, 쓰레기를 분류하는 일도 할 수 있다. 이는 인간의 언어를 이해하고 다양한 작업을 수행하는 범용 로봇의 시대가 더 빨리 도래할 수 있음을 암시한다.

구글이 공개한 CaP의 다른 시연 영상을 보면 실제로 로봇이 수십 가지의 서로 다른 명령을 수행하는 장면이 등장한다. 나무 블록을 특정 장소에 옮기거나 색깔이나 형태를 보고 해당 사물이 무엇인지(과일, 병 등) 인식해 종류별로 분류할 수 있으며 화이트보드 위에 그림을 그리거나 지우는 작업까지도 완벽하게 수행한다.

팔과 바퀴가 달린 로봇이 코카콜라 캔, 사과를 각각 재활용 쓰레기통과 일반 쓰레기통에 넣는 장면도 있다. 미국 IT 매체 테크크런치는 이에 대해 “실제 세계에서 발생하는 시나리오 기반으로 자체 코드를 계속 생성하는 시스템을 개발하기 위한 기초가 될 수 있을 것”이라고 평가했다. 기계적으로 복잡한 작업을 수행하게 만드는 일이 쉽지는 않겠지만, 인간의 언어를 기반으로 자체적으로 코드를 만들어 낼 수 있기 때문에 앞으로의 활용 가능성은 무궁무진할 수 있다는 분석이다.

AI로 미래 산업 지배력 강화하는 ‘구글’

이날 현장 시연에서는 로봇이 맥락을 이해하는 장면도 확인할 수 있었다. ‘무슨 과자를 제일 좋아하는지’ 물어본 후 ‘그 과자를 옮기라’고 순차적으로 명령을 내리자 맥락을 이해하고 정확히 과제를 완료했다. 앤디 쩡 구글 선임 연구 과학자는 “초콜릿이라는 명시적 단어가 아닌 ‘윌리 웡카(Willy Wonka, 동화 속 초콜릿 공장 설립자)’ 같은 은유적 표현을 활용해 로봇이 초콜릿을 선택하도록 유도할 수도 있다”고 설명했다. 기계가 마치 사람처럼 언어를 이해하고 사용한다는 의미다.

CaP는 ‘AI라는 두뇌를 장착한 로봇’이 미래에 어떤 일을 할 수 있을지 보여준 하나의 예시, 시작점이라고 할 수 있다. 범용 로봇의 상용화를 위해서는 관절을 움직이는 액추에이터(actuator)를 비롯한 기계 공학의 발전이 매우 중요하지만, 동작을 제어할 수 있는 두뇌의 발전은 더 중요하다는 점을 구글이 상기시킨 셈이다. 구글이 AI 연구 및 개발에 집중하는 이유가 여기에 있다.

구글은 특히 대형 언어 모델과 텍스트, 사진 등 다양한 양식의 정보를 동시에 이해할 수 있는 ‘멀티모달(Multimodal, 다중모드)’ 기술에서 탁월한 성과를 만들어 내왔다. 전 세계 검색 엔진 시장 점유율 91.88%를 자랑하는 구글이 확보한 다량의 텍스트 및 이미지 데이터를 고려할 때 구글이 AI 업계에서 차지하는 위상은 공고하다.

AI 기술의 중요성을 알기에 오픈AI 같은 AI 전문 기업 외에도 엔비디아, 메타(페이스북), 테슬라, 애플, 마이크로소프트 등 다양한 빅테크 기업이 이 분야에 막대한 자금을 쏟아붓고 있다.

테슬라가 휴머노이드 로봇에 집중하는 이유

구글이 ‘두뇌’에 집중하고 있다면 테슬라는 다른 방식으로 범용 로봇의 미래를 앞당기고 있다. 특히 지난 9월 30일 ‘AI 데이’에서 발표한 휴머노이드 로봇 ‘옵티머스(Optimus)’는 업계에 큰 충격을 안겼다.

이 로봇은 사람과 비슷한 다관절의 손을 장착했고, 한 손으로 9Kg 무게의 물건을 들 수 있게 설계됐다. 주요 관절은 400Kg에 달하는 그랜드 피아노를 들어 올릴 수 있는 힘을 가진 액추에이터가 적용됐다.

특히 인간과 비슷한 체격, 형태를 갖췄다는 게 가장 탁월한 점으로 평가된다. 휴머노이드는 바퀴가 달린 로봇, 4족 보행 로봇에 비해 설계와 제작이 훨씬 어렵기 때문이다. 2족 보행의 경우 걸을 때 무게 중심이 이동하기 때문에 균형 맞추기가 쉽지 않다. 사람처럼 섬세한 손가락 움직임을 구현하는 일 역시 까다로운 작업이다.

그러나 휴머노이드는 실제 사람이 활동하는 다양한 환경에서 임무를 수행할 수 있다는 큰 장점이 있다. 특정 환경에서만 사용하는 게 아니라 인간 기준으로 설계된 환경에 바로 투입 가능한 범용 로봇이 탄생할 수 있는 것이다. 테슬라는 전기차 대량 생산 기술을 기반으로 한 로봇의 대량 생산 및 이에 따른 가격 경쟁력까지 갖추고 있다. 범용 로봇 분야 미래 주도권을 확보하기 위한 빅테크 간의 경쟁이 앞으로 더 치열하게 벌어질 가능성이 크다.

전기 에너지 수요 급증… 서비스로서의 로봇 뜬다

그렇다면 AI 기반 범용 로봇은 어떤 변화를 가져올까?

전문가들은 AI 기반 범용 로봇 기술의 발전이 인간의 일상 생활을 보조하는 서비스 로봇의 시대를 열 것으로 예측하고 있다. 지금까지 로봇이 특정 기능 중심의 산업용 로봇, 군사용 로봇 중심으로 활용됐다면 앞으로는 인간처럼 다양한 작업을 수행할 수 있는 식당 서빙 로봇, 배달 로봇, 주방 로봇, 청소 로봇이 빠르게 생겨날 것이라는 전망이다. 시장조사업체 IDTechEX는 서비스 로봇의 시장 규모가 오는 2032년 700억달러에 이를 것으로 봤다.

범용 로봇의 증가는 또한 화석 연료 대신 배터리 중심의 전기 에너지 사용을 폭발적으로 늘릴 것이다. 서비스 로봇은 전기차와 더불어 일반 소비자가 사용하는 전자제품 중 가장 크고 무거우며 많은 에너지를 필요로 한다. 테슬라가 전기자동차와 로봇의 경계를 희미하게 만드는 일에 앞장서는 배경도 여기에 있다.

범용 로봇은 또한 기업의 고용 형태를 바꿀 것이다. 가격이 비싼 로봇을 구매하지 않고, 노동자들에게 임금을 지불하는 것처럼 시간당 비용을 지불하고 로봇을 고용하는 일이 벌어질 수 있다. 휴머노이드 범용 로봇의 본격적인 상용화 이전까지는 ‘엑소스켈레톤(Exoskeleton, 외골격 수트)’라고 부르는 입는 로봇 시장 분야가 빠르게 커질 것이란 예측도 나온다. 인간 직원의 부상, 보험료, 생산성 저하, 대체 인력 조달 등을 고려하면 많은 기업들이 비용 절감 차원에서 엑소스켈로톤을 작업장에 적용할 것이란 관측이다.

‘로봇의 부상’의 저자이자 미래학자인 마틴 포드는 “서비스로서의 로봇(robot as a service)의 도입이 예상된다. 로봇은 건강 관리, 휴가와 같은 혜택이 필요 없다”며 “결국 사람보다 로봇을 고용하는 것이 더 저렴해질 것으로 보인다”고 했다.

![[생활 속 에너지] AI 서비스, 어디까지 왔니? 6 [생활 속 에너지] AI 서비스, 어디까지 왔니? | 20201119 01 00 F](https://gscaltexmediahub.com/wp-content/uploads/2020/11/20201119_01_00_F.jpg)